13 (+3) KI- & AR-Impulse bei einer Tasse...

Zunächst möchte ich mich für die Fehlsendung am Mittwoch entschuldigen. Der Beitrag Von 2D zu 3D: Wie das Web spatial wird und was Unternehmen davon haben war als LinkedIn-Artikel geplant und... ich habe mich verklickt, so wurde ein Newsletter draus.

Wegen des heutigen Datums gibt es TROTZDEM die geplante Sommerausgabe und vermutlich in ca. 2 Wochen die nächste Ausgabe. Dann sind wir wieder im normalen Rhythmus.

Hier ist nun mein Sommerspecial, versendet an meinem 56. Geburtstag an die geschätzten Newsletter-LeserInnen auf LinkedIn. Ich genieße den Tag -wie jedes Jahr- bei einem Zoo-Spaziergang und IHR könnt Euch durch diese Impulse klicken.

Die letzten zwei Jahre gab es Podcast-Tipps für den Sommer, doch dieses Jahr habe ich einige meiner LinkedIn-Beiträge und -Artikel rausgesucht. Best-Of... Viel Spaß!

KI-Themen

Bei all dem Apple-KI-gebashe dachte ich mir... nehm ich doch mal den Gegenpart ein und verfasse meine Gedanken WARUM Apple so agiert WIE es agiert.

OpenAI plant ja DEN iPhone-Killer. Ok, ganz neu wurden die Infos schon wieder wegen eines Markenstreits gelöscht. Wie KÖNNTE aber eine Antwort von Apple aussehen?

All die KI-Tools und welches Bild ist ECHT? Es gibt Wege zur Kennzeichnung. Hier ein Weg erklärt...

Gedanken zu Suchmaschinenoptimierung #SEO und Answering Engine Optimitation #AEO.

Wie ich mich "Selbstmotiviere" in meiner Freizeit neue KI-Tools auszuprobieren.

Apple-Inspirationen

Was wäre der Unterschied zwischen einer Apple-Smartbrille und einer Meta-Smartbrille?

Wie Apple mit bestehender Hardware das Smartphone zu einem AR-Star machen könnte.

Wie Apple seine Kopfhörer als Smartbrillen-Alternative ausbauen könnte.

OpenUSD & Augmented Reality

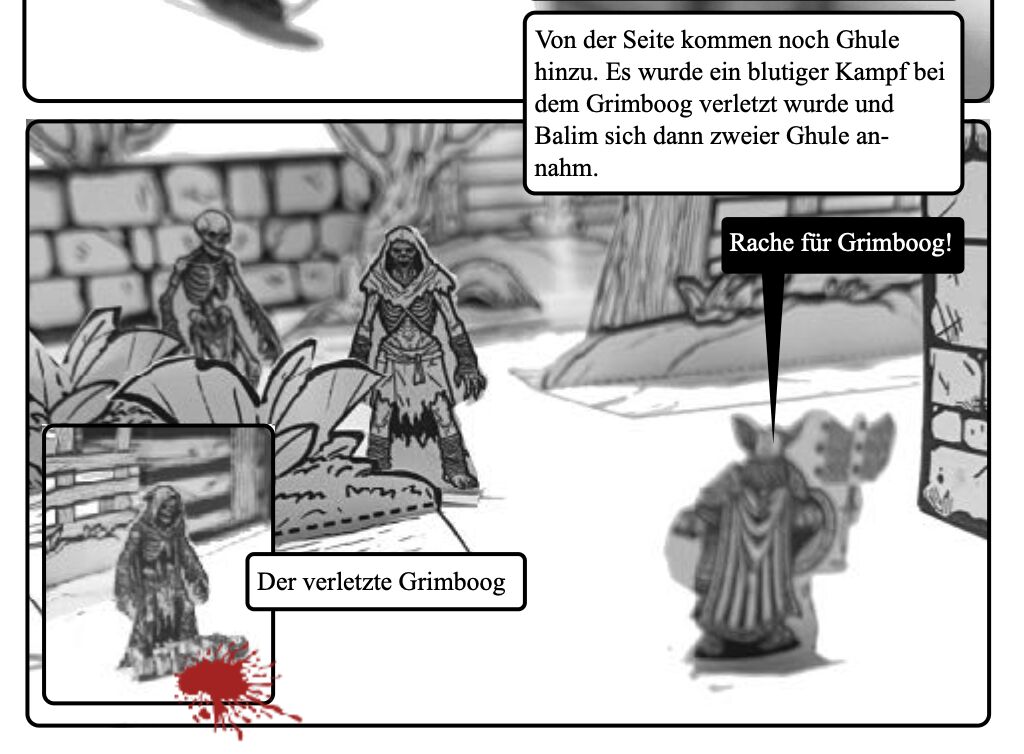

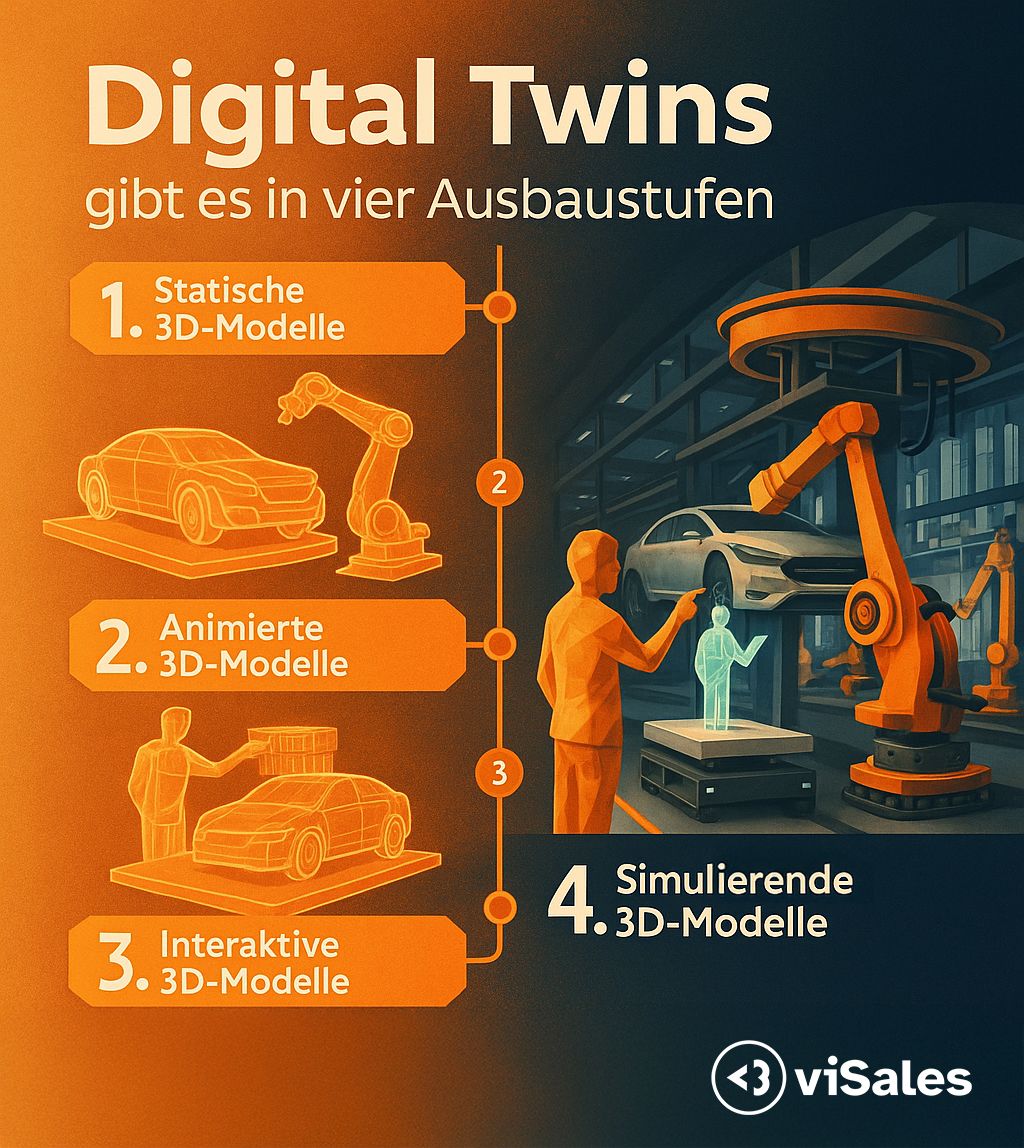

Zur letzten Newsletter-Ausgabe eine Infografik.

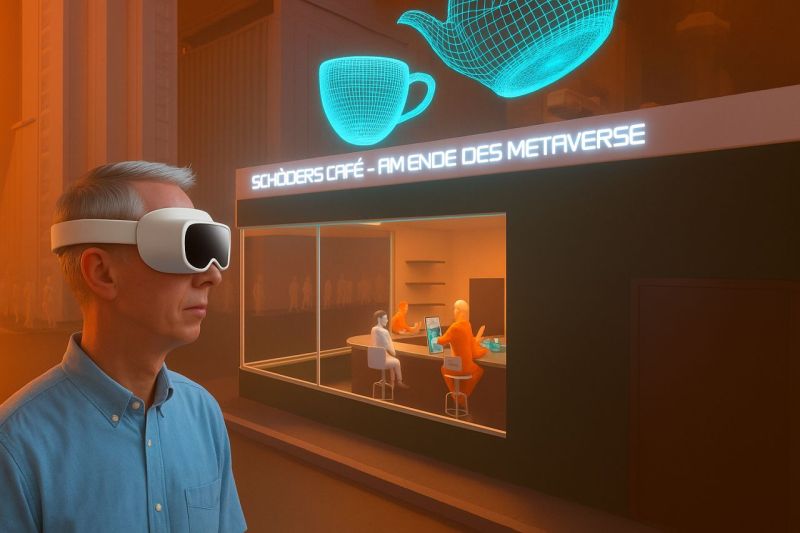

Zur vorletzten Newsletter-Ausgabe eine Bilderstrecke. Unbedingt ausprobieren!

Meine Gedanken nach der Apple-Entwicklerkonferenz.

Nachfragen dazu beantwortet.

"Probleme" mit 3D-Dateien.

Private Gedanken zum Ausklang

Ich bin ja ALT, aber die Idee vom Internet ist NOCH ÄLTER.

Rückbesinnung auf frühere Jahre...

Damit nun genug Links. Im Juli stellt meine Agentur ein neues Produkt vor, gleich im Kombi mit einem Referenzkunden. Klar, es geht dann wieder um Sales mit visuellen Mitteln, um AR und OpenUSD.

Viele Grüße aus Velbert

Gerhard Schröder

PS: Ok, einen Podcast-Tipp habe ich doch noch. Mark Zimmermann erwähnte mich in einer Folge des heise-Podcasts "TNBT". Ruhm fürs Team der Agentur viSales GmbH!